L'IA avec elle créez des designs qui inspirent.

Générez n’importe quelle image que vous pouvez imaginer à l’aide de l’IA.

Exemple avec ChatGPT (version gratuite) :

Ce sera la couverture de mon Guide Généalogique

GOUVERNANCE et TIC + Artificial Intelligence Veille technologique - Transmission du savoir - Ultra‑GAIA: version augmentée d’une IA planétaire

Ce sera la couverture de mon Guide Généalogique

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Sécurité de l'emploi : Les syndicats craignent que l'IA ne remplace des emplois, entraînant des pertes d'emplois et une augmentation du chômage.

Conditions de travail : Ils sont préoccupés par les impacts potentiels de l'IA sur les conditions de travail, notamment en termes de surveillance accrue et de pression sur les employés.

Formation et compétences : Les syndicats insistent sur la nécessité de former les travailleurs aux nouvelles compétences requises par l'IA pour éviter l'exclusion technologique.

Éthique et transparence : Ils demandent une réglementation stricte pour garantir que l'IA soit utilisée de manière éthique et transparente, afin de protéger les droits des travailleurs.

En résumé, les syndicats soutiennent une adoption responsable et équitable de l'IA, en mettant l'accent sur la protection des travailleurs et la promotion de l'équité sociale.

15 octobre 2024. Deux ans après le lancement des intelligences artificielles génératives grand public, l'école semble ensorcelée.

« À la rentrée 2024 on ne trouve pas un plan académique de formation sans proposition pour « enseigner et apprendre à l'ère de l'IA ». Au sein de la DNE (Direction du numérique pour l'éducation), une Communauté de Réflexion en Éducation sur l'Intelligence Artificielle (CREIA) « a pour ambition de mettre l'innovation et l'intelligence artificielle (IA) au coeur des pratiques pédagogiques et des réflexions en éducation. »

Cette obsession institutionnelle se lit aussi dans la lettre de saisine du Conseil Supérieur des Programmes de mars 2024 pour la refonte des programmes du Cycle 1 au Cycle 4. N. Belloubet appelle à « créer une culture de l'IA » à tous les niveaux et dans toutes les disciplines (lire ici notre analyse de l'ensemble des lettres de saisine) !

Enfin, Clara Chappaz, issue du monde des startups, est nommée « secrétaire d'État chargée de l'Intelligence artificielle et du numérique » auprès du Ministère de l'enseignement supérieur et de la recherche. Ce portefeuille et son rattachement au MESR sont deux nouveautés, puisque les personnes ayant précédemment occupé la fonction dépendaient de Bercy, et que l'IA n'était pas mise en avant particulièrement.

les programmes et la formation des personnels doivent introduire une réflexion critique sur les usages des IA et leurs conséquences. Pour cela, des recherches sur l'impact des IA sur le travail des élèves et des personnels sont à mener d'urgence, à l'écart du lobbying des acteurs ayant des intérêts lucratifs dans ce domaine. Lors du Congrès de La Rochelle de 2024, le SNES-FSU a actualisé et approfondi ses mandats pour un « numérique maîtrisé » : https://www.epi.asso.fr/revue/lu/l2411d.htm

https://www.snes.edu/article/un-numerique-maitrise-les-mandats-du-snes-fsu/

https://www.snes.edu/article/rentree-2024-offensives-sur-lia-dans-leducation/

Pour le SNES-FSU, les programmes et la formation des personnels doivent introduire une réflexion critique sur les usages des IA et leurs conséquences. Pour cela, des recherches sur l’impact des IA sur le travail des élèves et des personnels sont à mener d’urgence, à l’écart du lobbying des acteurs ayant des intérêts lucratifs dans ce domaine. Lors du Congrès de La Rochelle de 2024, le SNES-FSU a actualisé et approfondi ses mandats pour un “numérique maîtrisé”. ceci en fin 2024

Pour répondre aux enjeux et usages pédagogiques des services numériques utilisant l’intelligence artificielle en éducation, la Direction du numérique pour l'Éducation (DNE) propose un webinaire le 30 août 2024, de 13h30 à 14h30.

Seront présentés les enjeux, les perspectives 2024-2025 et des exemples de pratiques pédagogiques dans le cadre de la "CREIA" (Communauté de réflexion en éducation sur l'IA animée par les équipes du MENJ et celles académiques). Les chefs d'établissements et les équipes pédagogiques qui le souhaitent peuvent intégrer ce webinaire dans leur temps de pré-rentrée. Le webinaire est ouvert à tout personnel éducatif, enseignant, formateur ou cadre intéressé par le sujet de l’intelligence artificielle et de l’éducation.

>>> L’adresse de diffusion : https://videodiff.phm.education.gouv.fr/live/ia-et-education-rentree-20… https://www.ac-paris.fr/l-intelligence-artificielle-dans-l-education-130992

1. Position sur les GRETA (formation continue des adultes) :

- Le syndicat défend leur rôle essentiel comme service public de formation

- Il demande que ces formations restent accessibles à tous

- Il s'inquiète des fusions qui dégradent les conditions de travail

- Il critique l'utilisation des fonds de mutualisation

2. Position principale sur le numérique dans l'éducation :

Le syndicat adopte une position très critique et prudente sur la numérisation de l'éducation, avec plusieurs points majeurs :

- Il dénonce une numérisation "forcée" servant des intérêts économiques (EdTech) plus que pédagogiques

- Il s'inquiète de l'impact environnemental des équipements numériques

- Il critique le manque de concertation avec les enseignants sur les outils

- Il alerte sur les risques de l'IA dans l'éducation (inégalités, dépossession du métier)

- Il défend une approche raisonnée et limitée du numérique

3. Position sur le climat scolaire :

- Le syndicat rejette l'approche managériale du ministère

- Il critique l'introduction des "compétences psychosociales" dans l'éducation

- Il défend une vision plus globale du bien-être à l'école

Les positions du SNES-FSU apparaissent cohérentes et bien argumentées. Le syndicat adopte une posture de contre-pouvoir constructif en :

1. Défendant une vision de l'éducation centrée sur l'humain plutôt que sur la technologie

2. Alertant sur les risques réels de la numérisation précipitée (environnementaux, pédagogiques, sociaux)

3. Proposant des alternatives concrètes (ex: équipements durables, logiciels libres)

Sa position sur le numérique est particulièrement pertinente car elle ne rejette pas totalement les outils numériques mais plaide pour une utilisation réfléchie et maîtrisée, au service réel des apprentissages.

Le syndicat semble avoir une approche équilibrée qui reconnaît l'importance de la modernisation tout en restant vigilant sur ses dérives potentielles, notamment la marchandisation de l'éducation et la déshumanisation de l'enseignement.

C'est une question légitime qui mérite une analyse nuancée :

1. Sur la réalité du "retard" :

- Il faut d'abord questionner ce qu'on appelle "retard". Si on parle d'équipement pur (nombre de tablettes, d'ordinateurs...), certains pays sont en effet plus équipés. Mais l'équipement ne garantit pas l'efficacité pédagogique.

2. Quelques exemples internationaux intéressants :

- La Finlande, souvent citée pour son excellence éducative, privilégie une approche mesurée du numérique

- La Corée du Sud, très équipée numériquement, commence à faire marche arrière sur certains aspects en constatant les effets négatifs de la surexposition aux écrans

- L'Estonie, considérée comme très avancée numériquement, a développé ses outils progressivement, en formant d'abord les enseignants

3. Les vrais enjeux ne sont peut-être pas là :

- Le "retard" le plus problématique n'est pas tant dans l'équipement que dans la formation des enseignants et la réflexion sur les usages

- La question de la fracture numérique et des inégalités sociales reste cruciale

- L'urgence environnementale impose de repenser notre rapport à la technologie

4. Une autre approche possible :

- Plutôt que de chercher à rattraper un supposé retard, ne faudrait-il pas développer un modèle français original qui :

* Privilégie la qualité plutôt que la quantité

* Met l'accent sur la formation à l'esprit critique

* Développe une vraie sobriété numérique

* Garde l'humain au centre du processus éducatif

la question n'est peut-être pas tant celle du retard que celle du modèle éducatif que nous voulons construire. La course à l'équipement numérique ne doit pas faire oublier les fondamentaux de l'éducation : la transmission des savoirs, le développement de l'esprit critique et l'émancipation des élèves.

Le positionnement du SNES-FSU, qui appelle à une réflexion approfondie plutôt qu'à une numérisation précipitée, n'est donc pas nécessairement un frein au progrès, mais plutôt une invitation à repenser intelligemment notre rapport au numérique dans l'éducation.

Présentation réalisée dans le cadre du wébinaire "Usage de l'IA en éducation: retours d'expérience et perspectives" du mooc AI4T, https://inrialearninglab.github.io/ai...

Résumé: La curiosité joue un rôle clé dans les apprentissages chez les enfants, à l’école et en dehors. Elle est un des moteurs qui peut les amener à s’épanouir en prenant du plaisir à apprendre, en stimulant leur persévérance et leur créativité. Se basant sur ses travaux fondamentaux en sciences cognitives et en IA pour modéliser la curiosité chez les enfants, l’équipe Flowers à Inria travaille depuis plusieurs années à leur application dans le domaine de l’éducation. Je présente ici deux projets réalisés en collaboration entre l’équipe Flowers et l’entreprise edTech evidenceB. L’un utilise des méthodes de personnalisation des apprentissages qui stimulent la curiosité dans le cadre de l’apprentissage des maths, aujourd’hui diffusées à grande échelle dans le logiciel Adaptiv’Maths (plan P2IA du ministère de l’Education nationale) et accessible dans toutes les écoles en France (68.000 classes). L’autre où nous expérimentons les capacités très prometteuses des modèles de langage pour mettre en place des agents conversationnels qui entraînent les enfants à poser des questions curieuses. Je discute aussi des enjeux de la littératie en IA au collège et au lycée, et de plusieurs outils pédagogiques visant d’y contribuer.

Slides: Artificial Intelligence for and by Teachers https://inrialearninglab.github.io/ai4t//fr/

Liens:

Clément, B., Sauzéon, H., Roy, D., & Oudeyer, P. Y. (2024). Improved Performances and Motivation in Intelligent Tutoring Systems: Combining Machine Learning and Learner Choice. arXiv preprint arXiv:2402.01669. https://arxiv.org/abs/2402.01669

Abdelghani, R., Oudeyer, P. Y., Law, E., de Vulpillières, C., & Sauzéon, H. (2022). Conversational agents for fostering curiosity-driven learning. International Journal of Human-Computer Studies, https://hal.science/hal-03810322/docu...

Abdelghani, R., Wang, Y. H., Yuan, X., Wang, T., Lucas, P., Sauzéon, H., & Oudeyer, P. Y. (2023). Gpt-3-driven pedagogical agents to train children’s curious question-asking skills. International Journal of Artificial Intelligence in Education, 1-36. https://arxiv.org/pdf/2211.14228.pdf

Abdelghani, R., Sauzéon, H., & Oudeyer, P. Y. (2023). Generative AI in the Classroom: Can Students Remain Active Learners?. arXiv preprint arXiv:2310.03192. https://arxiv.org/abs/2310.03192

Torres-Leguet, A., Romac, C., Carta, T., Oudeyer, P-Y. (2023) ChatGPT en 5mn: une série pédagogique pour le grand public, CC-BY, https://developmentalsystems.org/chat...

Présentation des ressources AI4T¶ https://inrialearninglab.github.io/ai4t//fr/2-Project-resources/0-presentation/0-1-presentation-AI4T-resources.html

Vous trouverez ici les documents, ressources et outils qui ont contribué au projet, de sa conception à sa mise en œuvre dans le cadre de l'expérimentation AI4T.

La plupart de ces ressources sont en anglais, Italien, Allemand, Français.

Elles sont organisées en trois sections :

Section 1 - Outils d'IA (éducative) utilisés pendant la phase d'expérimentation dans les 5 pays

Section 2 - Liste des Moocs et des ressources en ligne liés à l'IA ou à l'IA et l'éducation

Section 3 - Rapports et lignes directrices relatifs à l'IA et à l'éducation

* *Une priorité gouvernementale:* L'IA est devenue une priorité pour le ministère de l'Éducation nationale. La rentrée 2024 a marqué une accélération de cette tendance, avec de nombreux plans académiques proposant des formations à l'IA.

* *Des outils pédagogiques innovants:* Des plateformes numériques utilisant l'IA voient le jour, proposant des parcours d'apprentissage personnalisés et des exercices adaptés au niveau de chaque élève.

* *Une expérimentation en cours:* Le projet "MIA Seconde" vise à accompagner les élèves de seconde grâce à l'IA, mais son déploiement est encore en cours et rencontre quelques difficultés.

* *Des formations pour les enseignants:* Des initiatives comme le projet européen "AI4T" visent à former les enseignants à l'utilisation de l'IA en classe.

* *Un manque de cadre structuré:* L'intégration de l'IA dans l'éducation se fait de manière hétérogène, sans véritable plan d'ensemble.

* *Des questions éthiques:* L'utilisation de l'IA soulève de nombreuses questions sur la protection des données, la neutralité algorithmique et l'impact sur l'autonomie des élèves.

* *Un besoin de formation approfondie:* Les enseignants ont besoin de formations solides pour utiliser efficacement les outils d'IA et accompagner leurs élèves.

L'IA offre de nombreuses possibilités pour améliorer l'enseignement et l'apprentissage. Cependant, pour que cette technologie soit pleinement exploitée, il est nécessaire de mettre en place un cadre clair, de former les enseignants et de réfléchir aux enjeux éthiques.

Pour en savoir plus, vous pouvez consulter ces ressources:

* *L'intelligence artificielle progresse dans l'Éducation nationale:* [https://actionetdemocratie.com/l-intelligence-artificielle-progresse-dans-l-education-nationale/](https://actionetdemocratie.com/l-intelligence-artificielle-progresse-dans-l-education-nationale/)

* *Intelligence artificielle à l'école:* [https://www.banquedesterritoires.fr/lintelligence-artificielle-lecole-entre-promesses-et-defis](https://www.banquedesterritoires.fr/lintelligence-artificielle-lecole-entre-promesses-et-defis)

* *Rentrée 2024 : offensives sur l'IA dans l'éducation:* https://www.snes.edu/article/rentree-2024-offensives-sur-lia-dans-leducation/

Qu'en pensez-vous? Faut-il confier ces formations au secteur privé ?

- Lourdeur administrative- Délais d'adaptation longs- Formation continue parfois insuffisante- Résistance au changement

Avantages :- Plus grande réactivité- Innovation technologique rapide- Méthodes modernes- Capacité d'investissement

- Logique de profit qui peut primer sur la qualité pédagogique- Creusement des inégalités sociales- Perte de contrôle sur les données des élèves- Standardisation de l'enseignement- Dépendance vis-à-vis d'acteurs privés

- Garder le pilotage public de l'éducation- Moderniser l'Éducation nationale de l'intérieur- Développer des partenariats public-privé encadrés- Maintenir une régulation forte sur les contenus et méthodes- S'inspirer des bonnes pratiques du privé tout en préservant les valeurs du service public

- Préserve l'égalité d'accès à l'éducation- Garantisse la qualité pédagogique- Protège les données personnelles- Maintienne l'indépendance du service public- Permette l'innovation tout en gardant un contrôle sur les processus

Lu sur le Net : Rentrée 2024 : offensives sur l'IA dans l'éducation

https://www.epi.asso.fr/revue/lu/l2411d.htm

Groupes thématiques numériques – Éducation, numérique et recherche

https://edunumrech.hypotheses.org/category/gtnum

https://edunumrech.hypotheses.org/12941

https://inrialearninglab.github.io/ai4t//fr/

https://www.inria.fr/fr/intelligence-artificielle

https://www.ai4t.eu/deliverables/

https://www.youtube.com/watch?v=9t-fm4liJPw&t=14s

https://edunumrech.hypotheses.org/8350

https://www.microsoft.com/fr-fr/education/products/office?msockid=3285acb143b16ea9246bb9b042c66f1b

https://aws.amazon.com/fr/education/awseducate/

https://about.meta.com/meta-for-education/

https://www.apple.com/fr/education/

https://academy.nvidia.com/en/

https://inrialearninglab.github.io/ai4t//fr/index.html MOOC.

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Par Gwenaël Bego

Dans l’environnement commercial d’aujourd’hui, il est essentiel de rationaliser les flux de travail et de réduire les tâches manuelles. Microsoft AI Builder apporte la puissance de l’automatisation avancée aux processus de routine tels que le traitement des e-mails, le traitement des documents et la gestion des images, aidant ainsi les entreprises à fonctionner plus intelligemment et plus efficacement. Grâce à de nouvelles fonctionnalités, notamment le traitement de contenu multimodal, les sorties JSON structurées, la sélection flexible de modèles, l’ancrage Dataverse et une vaste bibliothèque d’invites, AI Builder élève les agents, les applications et l’automatisation à un niveau supérieur d’impact commercial.

L’une des mises à jour les plus révolutionnaires d’AI Builder est la nouvelle capacité de traitement de contenu multimodal, qui permet aux entreprises de gérer différents types de données, y compris du texte, des documents et des images, dans le cadre d’une seule instruction en langage naturel. Cette intégration simplifie considérablement le processus d’élaboration d’actions d’IA pour un traitement intelligent des documents. Contrairement aux modèles d’apprentissage automatique traditionnels qui nécessitent une formation et une expertise approfondies, le traitement multimodal d’AI Builder peut être configuré à l’aide du langage naturel et sans données d’entraînement.

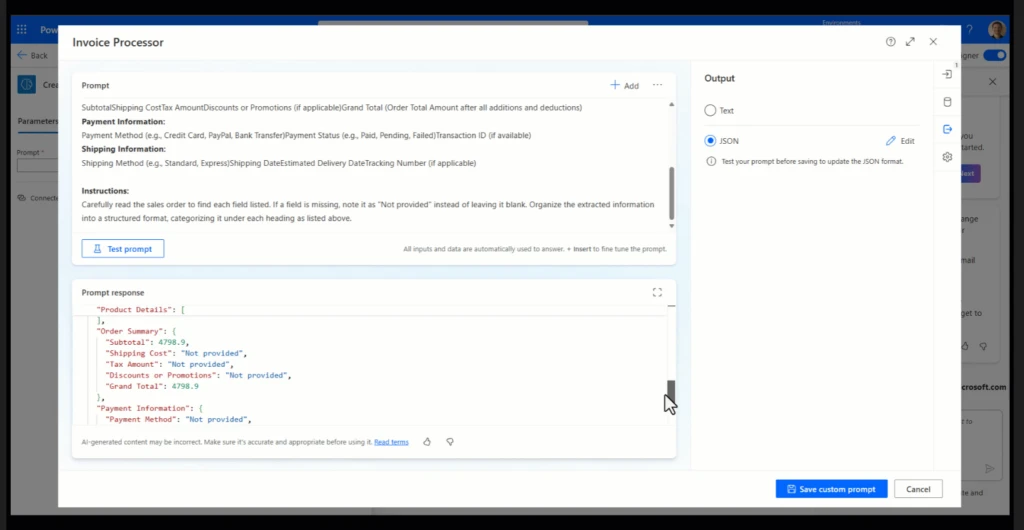

Grâce à la nouvelle fonctionnalité de sortie JSON structurée d’AI Builder, les entreprises disposent d’un moyen plus déterministe et plus fiable de gérer le contenu généré. Contrairement aux sorties traditionnelles dont le format et la structure peuvent varier, les sorties JSON sont désormais générées avec un schéma prédéfini cohérent que vous définissez au moment de la conception, ce qui garantit que chaque résultat s’aligne précisément sur les formats de données attendus. Ce déterminisme dans la génération de contenu signifie que vos flux de travail automatisés produiront à chaque fois des données prévisibles et structurées, et que ces résultats seront facilement intégrés en tant que variables dans votre flux de travail Power Automate pour le traitement en aval. Cette fonctionnalité est particulièrement bénéfique lors de l’intégration des sorties d’AI Builder dans d’autres systèmes, car elle réduit le besoin de nettoyage ou de transformation de données supplémentaires. Qu’il s’agisse d’alimenter un CRM, une base de données ou une application personnalisée, vous pouvez vous assurer que les données sont générées de manière structurée et prévisible.

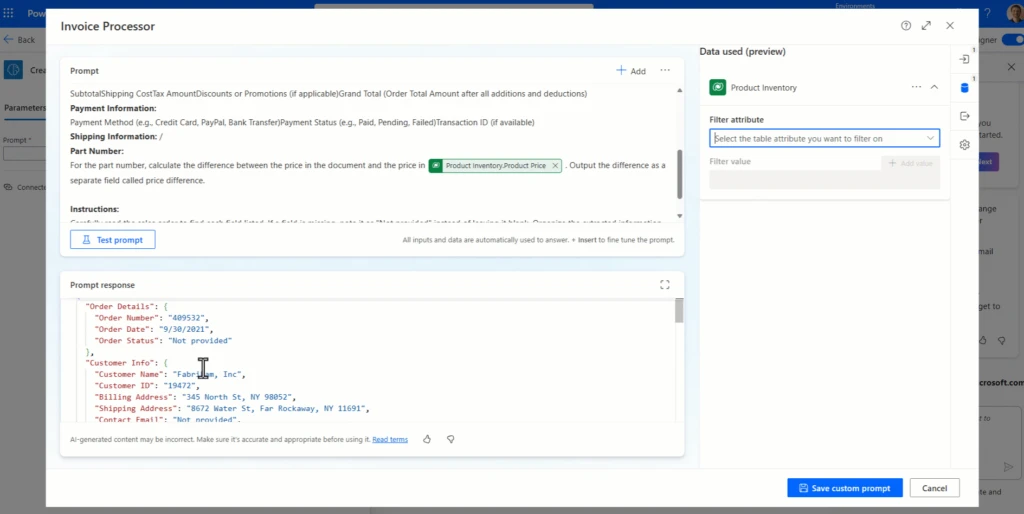

La nouvelle fonctionnalité d’ancrage Dataverse permet aux modèles d’IA générative d’obtenir des informations actualisées et contextuellement pertinentes à partir des données de votre organisation. En utilisant la génération augmentée par récupération (RAG), AI Builder s’intègre directement à Dataverse pour extraire des connaissances en temps réel et spécifiques à l’entreprise, donnant aux modèles une compréhension plus approfondie de votre contexte unique.

Cette approche améliorée par RAG permet aux modèles d’IA de récupérer et d’incorporer dynamiquement des données pertinentes de Dataverse pendant le traitement, ce qui permet d’obtenir des scénarios de questions-réponses avec des réponses précises qui sont également hautement contextualisées pour votre organisation. Par exemple, les modèles peuvent accéder instantanément aux historiques des clients, aux informations sur les produits et aux données opérationnelles les plus récentes, enrichissant ainsi les résultats avec des connaissances directement ancrées dans votre réalité commerciale.

Dans le cadre de la mise à disposition générale de cette fonctionnalité, elle a été améliorée pour prendre en charge plusieurs tables, y compris les tables contenant de grandes quantités d’enregistrements de données.

AI Builder offre une flexibilité dans la sélection des modèles, permettant aux utilisateurs de choisir entre le puissant GPT-4o et le GPT-4o Mini économique. Cette adaptabilité permet une personnalisation en fonction des exigences spécifiques du projet et des considérations relatives aux ressources.

La fonctionnalité de bibliothèque d’invites fournit une collection d’invites prédéfinies, servant de modèles pour accélérer la création de modèles d’IA. Cette ressource accélère le développement et garantit que les meilleures pratiques sont suivies dans l’ingénierie rapide. Les utilisateurs peuvent modifier les modèles en fonction de leurs besoins spécifiques, en ajustant le langage, le ton et les détails pour correspondre aux normes et aux exigences de l’organisation. Les modèles couvrent des domaines clés tels que l’extraction de documents, la transformation des données et la génération de contenu, ce qui permet aux utilisateurs de trouver facilement le bon point de départ pour leurs objectifs d’automatisation intelligente.

Avec AI Builder, vous n’avez pas besoin d’être un expert en codage pour tirer parti de la puissance de l’IA dans vos opérations quotidiennes. En créant des invites capables d’extraire des informations de documents, de classer des e-mails et même d’analyser des images, vous pouvez donner à votre équipe les moyens de travailler plus intelligemment, et non plus durement. AI Builder fonctionne main dans la main avec d’autres outils Power Platform tels que Power Automate, Copilot Studio et Power Apps, ce qui permet aux utilisateurs de créer des flux de travail intelligents et des applications personnalisées pour répondre aux besoins de toute entreprise.

Par exemple, supposons que votre équipe traite fréquemment les demandes des clients. À l’aide d’AI Builder et de Power Automate, vous pouvez concevoir un flux de travail qui analyse le contenu des e-mails entrants, les catégorise par urgence ou par sujet, et suggère même des réponses. Cela permet non seulement de gagner du temps, mais aussi de maintenir une communication cohérente et efficace. En mettant en place ce flux automatisé, les entreprises peuvent garder le contrôle des interactions avec les clients et garantir des réponses rapides.

Êtes-vous prêt à intégrer l’IA dans votre organisation ?

La documentation d’AI Builder fournit un guide complet sur la configuration d’AI Builder, la configuration des modèles et son intégration à des outils tels que Power Automate et Power Apps.

https://learn.microsoft.com/en-us/ai-builder/overview

Pour des didacticiels étape par étape, le parcours d’apprentissage Microsoft Learn AI Builder est un excellent point de départ. Il couvre tout, des concepts fondamentaux aux cas d’utilisation avancés, aidant les utilisateurs de tous niveaux à maîtriser l’utilisation d’AI Builder pour automatiser et optimiser les flux de travail.

Pour obtenir des conseils et des exemples sur l’utilisation du traitement de contenu multimodal et d’autres invites avec Power Apps, vous pouvez utiliser le Creative AI Kit dans App Source ou GitHub. Les nouveaux exemples qui utilisent des invites multimodales incluent AI Image Diff, AI Describe Image, AI Fields from Image et AI Generate QnA.

https://github.com/microsoft/powercat-creator-kit/releases/tag/CreatorKit-November2024

Participez à nos sessions Ignite et découvrez d’autres annonces passionnantes pour Microsoft Power Platform :

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Maintenant que les blockchains et les IA deviennent de plus en plus puissantes, il existe un nombre croissant de cas d’utilisation à l’intersection des deux domaines. Cependant, certains de ces cas d’utilisation ont beaucoup plus de sens et sont beaucoup plus robustes que d’autres. En général, les cas d’utilisation où le mécanisme sous-jacent continue d’être conçu grossièrement comme avant, mais où les acteurs individuels deviennent des IA, permettant au mécanisme de fonctionner efficacement à une échelle beaucoup plus micro, sont les plus prometteurs et les plus faciles à réaliser.

Les applications les plus difficiles à mettre en œuvre sont celles qui tentent d’utiliser des blockchains et des techniques cryptographiques pour créer un « singleton » : une IA de confiance décentralisée unique sur laquelle une application s’appuierait à une certaine fin. Ces applications sont prometteuses, à la fois pour la fonctionnalité et pour l’amélioration de la sécurité de l’IA d’une manière qui évite les risques de centralisation associés à des approches plus courantes de ce problème. Mais il y a aussi de nombreuses façons dont les hypothèses sous-jacentes pourraient échouer ; Par conséquent, il vaut la peine d’être prudent, en particulier lors du déploiement de ces applications dans des contextes à forte valeur et à haut risque.

J’ai hâte de voir d’autres tentatives de cas d’utilisation constructifs de l’IA dans tous ces domaines, afin que nous puissions voir lesquels d’entre eux sont vraiment viables à grande échelle.

https://github.com/0xfreysa/agent

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/