L'IA avec elle créez des designs qui inspirent.

Générez n’importe quelle image que vous pouvez imaginer à l’aide de l’IA.

Exemple avec ChatGPT (version gratuite) :

Ce sera la couverture de mon Guide Généalogique

GOUVERNANCE et TIC + Artificial Intelligence Veille technologique - Transmission du savoir - Ultra‑GAIA: version augmentée d’une IA planétaire

Ce sera la couverture de mon Guide Généalogique

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Par Gwenaël Bego

Dans l’environnement commercial d’aujourd’hui, il est essentiel de rationaliser les flux de travail et de réduire les tâches manuelles. Microsoft AI Builder apporte la puissance de l’automatisation avancée aux processus de routine tels que le traitement des e-mails, le traitement des documents et la gestion des images, aidant ainsi les entreprises à fonctionner plus intelligemment et plus efficacement. Grâce à de nouvelles fonctionnalités, notamment le traitement de contenu multimodal, les sorties JSON structurées, la sélection flexible de modèles, l’ancrage Dataverse et une vaste bibliothèque d’invites, AI Builder élève les agents, les applications et l’automatisation à un niveau supérieur d’impact commercial.

L’une des mises à jour les plus révolutionnaires d’AI Builder est la nouvelle capacité de traitement de contenu multimodal, qui permet aux entreprises de gérer différents types de données, y compris du texte, des documents et des images, dans le cadre d’une seule instruction en langage naturel. Cette intégration simplifie considérablement le processus d’élaboration d’actions d’IA pour un traitement intelligent des documents. Contrairement aux modèles d’apprentissage automatique traditionnels qui nécessitent une formation et une expertise approfondies, le traitement multimodal d’AI Builder peut être configuré à l’aide du langage naturel et sans données d’entraînement.

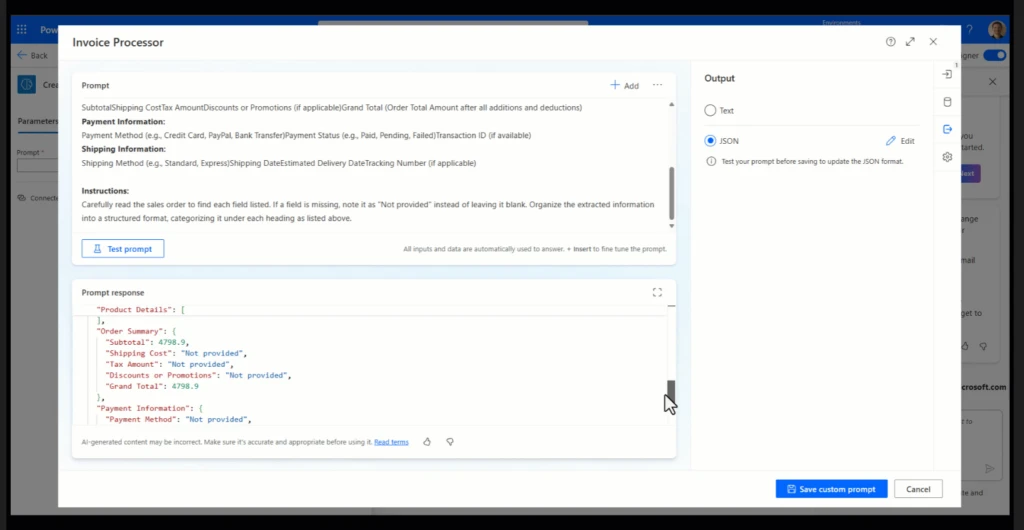

Grâce à la nouvelle fonctionnalité de sortie JSON structurée d’AI Builder, les entreprises disposent d’un moyen plus déterministe et plus fiable de gérer le contenu généré. Contrairement aux sorties traditionnelles dont le format et la structure peuvent varier, les sorties JSON sont désormais générées avec un schéma prédéfini cohérent que vous définissez au moment de la conception, ce qui garantit que chaque résultat s’aligne précisément sur les formats de données attendus. Ce déterminisme dans la génération de contenu signifie que vos flux de travail automatisés produiront à chaque fois des données prévisibles et structurées, et que ces résultats seront facilement intégrés en tant que variables dans votre flux de travail Power Automate pour le traitement en aval. Cette fonctionnalité est particulièrement bénéfique lors de l’intégration des sorties d’AI Builder dans d’autres systèmes, car elle réduit le besoin de nettoyage ou de transformation de données supplémentaires. Qu’il s’agisse d’alimenter un CRM, une base de données ou une application personnalisée, vous pouvez vous assurer que les données sont générées de manière structurée et prévisible.

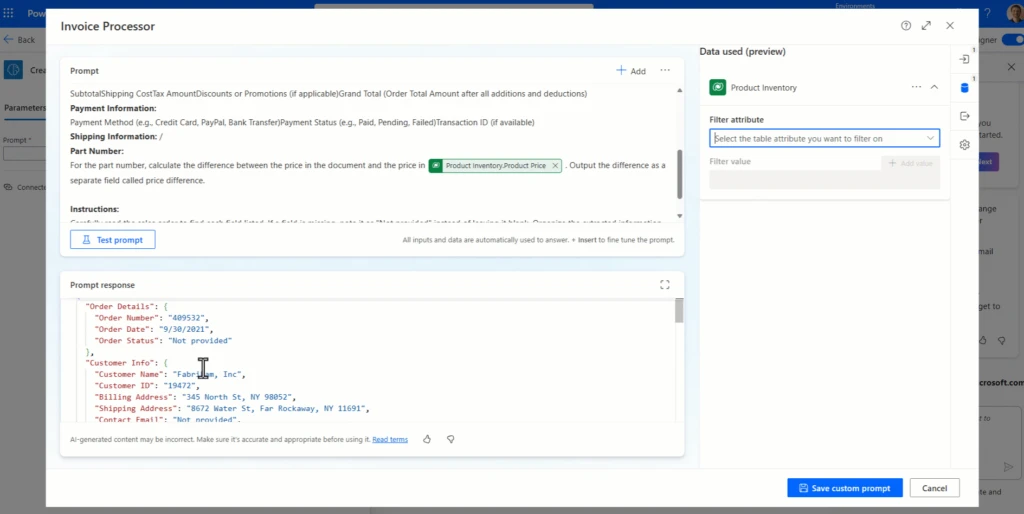

La nouvelle fonctionnalité d’ancrage Dataverse permet aux modèles d’IA générative d’obtenir des informations actualisées et contextuellement pertinentes à partir des données de votre organisation. En utilisant la génération augmentée par récupération (RAG), AI Builder s’intègre directement à Dataverse pour extraire des connaissances en temps réel et spécifiques à l’entreprise, donnant aux modèles une compréhension plus approfondie de votre contexte unique.

Cette approche améliorée par RAG permet aux modèles d’IA de récupérer et d’incorporer dynamiquement des données pertinentes de Dataverse pendant le traitement, ce qui permet d’obtenir des scénarios de questions-réponses avec des réponses précises qui sont également hautement contextualisées pour votre organisation. Par exemple, les modèles peuvent accéder instantanément aux historiques des clients, aux informations sur les produits et aux données opérationnelles les plus récentes, enrichissant ainsi les résultats avec des connaissances directement ancrées dans votre réalité commerciale.

Dans le cadre de la mise à disposition générale de cette fonctionnalité, elle a été améliorée pour prendre en charge plusieurs tables, y compris les tables contenant de grandes quantités d’enregistrements de données.

AI Builder offre une flexibilité dans la sélection des modèles, permettant aux utilisateurs de choisir entre le puissant GPT-4o et le GPT-4o Mini économique. Cette adaptabilité permet une personnalisation en fonction des exigences spécifiques du projet et des considérations relatives aux ressources.

La fonctionnalité de bibliothèque d’invites fournit une collection d’invites prédéfinies, servant de modèles pour accélérer la création de modèles d’IA. Cette ressource accélère le développement et garantit que les meilleures pratiques sont suivies dans l’ingénierie rapide. Les utilisateurs peuvent modifier les modèles en fonction de leurs besoins spécifiques, en ajustant le langage, le ton et les détails pour correspondre aux normes et aux exigences de l’organisation. Les modèles couvrent des domaines clés tels que l’extraction de documents, la transformation des données et la génération de contenu, ce qui permet aux utilisateurs de trouver facilement le bon point de départ pour leurs objectifs d’automatisation intelligente.

Avec AI Builder, vous n’avez pas besoin d’être un expert en codage pour tirer parti de la puissance de l’IA dans vos opérations quotidiennes. En créant des invites capables d’extraire des informations de documents, de classer des e-mails et même d’analyser des images, vous pouvez donner à votre équipe les moyens de travailler plus intelligemment, et non plus durement. AI Builder fonctionne main dans la main avec d’autres outils Power Platform tels que Power Automate, Copilot Studio et Power Apps, ce qui permet aux utilisateurs de créer des flux de travail intelligents et des applications personnalisées pour répondre aux besoins de toute entreprise.

Par exemple, supposons que votre équipe traite fréquemment les demandes des clients. À l’aide d’AI Builder et de Power Automate, vous pouvez concevoir un flux de travail qui analyse le contenu des e-mails entrants, les catégorise par urgence ou par sujet, et suggère même des réponses. Cela permet non seulement de gagner du temps, mais aussi de maintenir une communication cohérente et efficace. En mettant en place ce flux automatisé, les entreprises peuvent garder le contrôle des interactions avec les clients et garantir des réponses rapides.

Êtes-vous prêt à intégrer l’IA dans votre organisation ?

La documentation d’AI Builder fournit un guide complet sur la configuration d’AI Builder, la configuration des modèles et son intégration à des outils tels que Power Automate et Power Apps.

https://learn.microsoft.com/en-us/ai-builder/overview

Pour des didacticiels étape par étape, le parcours d’apprentissage Microsoft Learn AI Builder est un excellent point de départ. Il couvre tout, des concepts fondamentaux aux cas d’utilisation avancés, aidant les utilisateurs de tous niveaux à maîtriser l’utilisation d’AI Builder pour automatiser et optimiser les flux de travail.

Pour obtenir des conseils et des exemples sur l’utilisation du traitement de contenu multimodal et d’autres invites avec Power Apps, vous pouvez utiliser le Creative AI Kit dans App Source ou GitHub. Les nouveaux exemples qui utilisent des invites multimodales incluent AI Image Diff, AI Describe Image, AI Fields from Image et AI Generate QnA.

https://github.com/microsoft/powercat-creator-kit/releases/tag/CreatorKit-November2024

Participez à nos sessions Ignite et découvrez d’autres annonces passionnantes pour Microsoft Power Platform :

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Une expertise débloquée pour chaque utilisateur

- Plus autonomes que les assistants classiques (Siri, Alexa)- Capacité d'action proactive et d'adaptation en temps réel- Apprentissage continu basé sur leurs actions passées

- Microsoft : Intégration dans Dynamics 365 pour l'automatisation des processus métier- Amazon : Personnalisation de l'expérience client et gestion des recommandations

- Augmentation de la productivité- Réduction des coûts opérationnels- Prise de décision basée sur les données- Automatisation des tâches répétitives

- Sécurité des données sensibles- Transparence des décisions automatisées- Respect des principes éthiques

- Santé : Analyse des dossiers médicaux- Finance : Détection des fraudes- Industrie : Maintenance prédictive

- Démocratisation vers les PME- Intégration dans les objets connectés- Évolution vers des décisions plus complexes

Install-PSResource Microsoft.PowerShell.AIShell -PreRelease

Pour plus d'infos : aka.ms/AIShell-Docs

https://learn.microsoft.com/fr-fr/training/modules/introduction-to-powershell/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Compréhension de base des produits et services Microsoft 365Compréhension de base des produits et services de sécurité des données Microsoft PurviewCompréhension de base des produits et services de conformité des données Microsoft Purview

Microsoft Edge (fonctionne en mode natif)Google Chrome (nécessite l’extension Microsoft Purview)Mozilla Firefox (nécessite l’extension Microsoft Purview)

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Aujourd’hui, nous sommes ravis de franchir une nouvelle étape importante et d’introduire une nouvelle clé Copilot pour les PC Windows 11. En cette nouvelle année, nous inaugurerons un changement significatif vers un avenir informatique plus personnel et intelligent où l’IA sera intégrée de manière transparente à Windows, du système au silicium en passant par le matériel. Cela simplifiera non seulement l’expérience informatique des gens, mais l’amplifiera également, faisant de 2024 l’année du PC IA.

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Pour finir j’ai utilisé la solution nemotron-mini:latest car l’autres nemotron:latest me demande trop de ressources sur mon PC-AI.

Remarque : ce modèle est une démonstration de nos techniques visant à améliorer l'efficacité des instructions dans le domaine général. Il n'a pas été optimisé pour les performances dans des domaines spécialisés tels que les mathématiques.

Vous pouvez utiliser le modèle en utilisant la bibliothèque HuggingFace Transformers avec 2 ou plusieurs GPU de 80 Go (NVIDIA Ampere ou plus récent) avec au moins 150 Go d'espace disque libre pour permettre le téléchargement.

Ce code a été testé sur Transformers v4.44.0, torch v2.4.0 et 2 GPU A100 80 Go, mais toute configuration prenant en charge meta-llama/Llama-3.1-70B-Instructce modèle devrait également le prendre en charge. Si vous rencontrez des problèmes, vous pouvez envisager de faire pip install -U transformers.

https://huggingface.co/nvidia/Llama-3.1-Nemotron-70B-Instruct-HF

Le déployer sur Google Cloud : https://console.cloud.google.com/vertex-ai/model-garden/featured-partners/hugging-face

Si vous avez des questions supplémentaires ou rencontrez des problèmes, n'hésitez pas à demander !

Préparer l'environnement :

Assurez-vous d'avoir Docker installé sur votre système1.

Téléchargez et installez Docker si ce n'est pas déjà fait.

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/

Veille technologique - TIC - Gouvernance - AI - GPT (Teams, INSIDER Windows 11, INSIDER MICROSOFT 365, BETA TESTS Edge et Bing, et veille technologique sur les GAFAM+N), j'ai publié deux livres sur les solutions Microsoft et l'AI et Copilot (c'est le quatrième aux formats ePUB et Papiers). Je pratique la Veille technologique active sur les TIC, Copilot, Ollama, LLAMA, Claude 3.5 Sonnet, Gemini, Bing, ChatGPT et AI et je suis membre de AIDAUG et UGAIA, GUILD4AI - "Association de fait" http://www.ugaia.eu https://ugaia.wordpress.com/ https://lecercle.guild4ai.ai/